Giuseppe Barile

31 mar 2025

Del laboratorio a la realidad: los modelos Visión-Lenguaje-Acción están revolucionando la interacción entre los robots y el mundo físico.

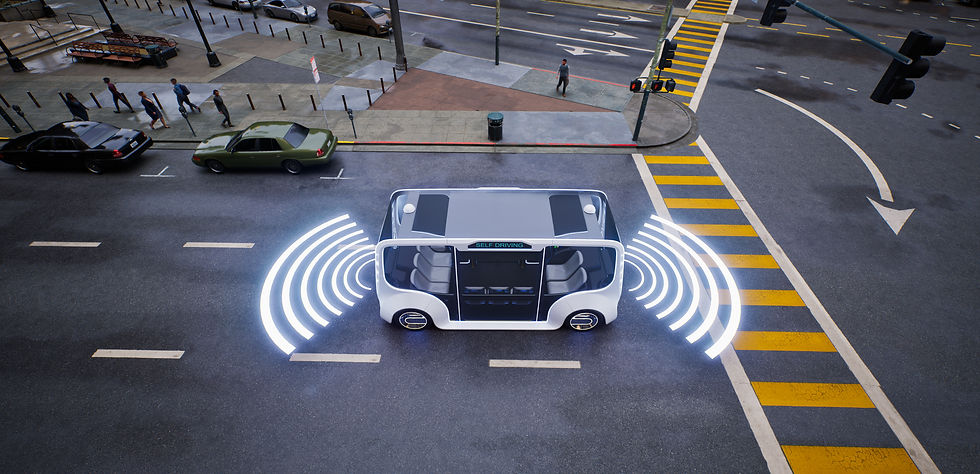

Los modelos Vision-Language-Action (VLA) representan la vanguardia de la inteligencia artificial aplicada a la robótica, con un impacto significativo en sectores como la automatización industrial, la navegación autónoma y la asistencia sanitaria. Estos sistemas multimodales combinan percepción visual, comprensión lingüística y capacidad de acción, creando robots capaces de interactuar con el mundo físico de manera más natural y eficiente. La investigación en este campo avanza rápidamente, abriendo nuevas posibilidades y desafíos.

En el núcleo de los modelos VLA hay tres módulos fundamentales que trabajan conjuntamente para procesar información visual y lingüística y responder con acciones precisas. El primer módulo, dedicado a la visión, utiliza redes neuronales avanzadas como las CNN (Convolutional Neural Networks) y modelos ViT (Vision Transformers) para extraer información de las imágenes. Estos son capaces de reconocer objetos, escenas y situaciones complejas, gracias al preentrenamiento con grandes conjuntos de datos. En este contexto, también se emplean técnicas de segmentación semántica para mejorar la comprensión espacial y la detección de objetos.

El segundo módulo está dedicado al lenguaje natural. Aquí se emplean modelos transformer de última generación como BERT, T5, GPT-4 y PaLM 2 para procesar y generar respuestas lingüísticas coherentes. Estos modelos se entrenan con grandes corpus de datos y utilizan métodos avanzados como la atención cruzada y el few-shot learning para adaptarse rápidamente a nuevos contextos, incluso cuando la información disponible es limitada. El objetivo es asegurar que el sistema pueda correlacionar correctamente palabras e imágenes para comprender el lenguaje en relación con los estímulos visuales.

El tercer módulo se refiere a la acción. Se utilizan algoritmos avanzados de toma de decisiones, como el reinforcement learning (RL), para decidir y ejecutar acciones. Gracias a técnicas como Proximal Policy Optimization (PPO) y redes neuronales para la planificación del movimiento, estos sistemas generan trayectorias óptimas de acción, adaptándose dinámicamente a las situaciones que se presentan. El aprendizaje por imitación, que permite al robot aprender observando las acciones humanas, es otro aspecto clave en la evolución de estas tecnologías.

Un aspecto innovador en la investigación sobre modelos VLA es el uso de la fusión multimodal. Mecanismos como la atención cruzada multimodal y la utilización de espacios de embedding comunes permiten integrar de manera fluida información visual y lingüística, mejorando la capacidad de generar respuestas coherentes y acciones precisas. Los modelos más avanzados, como Flamingo de DeepMind, utilizan enfoques de atención generalizada capaces de correlacionar eficientemente datos provenientes de diferentes modalidades, mientras que técnicas como el contrastive learning afinan la alineación semántica entre visión y lenguaje.

Las aplicaciones de los modelos VLA son amplias y variadas. En robótica, la capacidad de comprender e interactuar con el entorno en tiempo real hace que estos modelos sean ideales para tareas complejas como la manipulación de objetos o la navegación autónoma. En particular, proyectos como RT-2, que integran modelos preentrenados a gran escala con el control robótico, pueden mejorar significativamente el rendimiento de sistemas robóticos, incluso en entornos no explorados previamente. Modelos de código abierto como OpenVLA, con su enfoque versátil y altamente eficiente, están demostrando cómo la robótica puede beneficiarse de los sistemas VLA para mejorar la precisión y adaptabilidad en contextos reales. Sin embargo, existen importantes desafíos por superar. Una de las principales dificultades es la adaptabilidad en escenarios reales, donde las condiciones pueden variar enormemente con respecto a los datos de entrenamiento. Además, la eficiencia computacional sigue siendo una barrera, ya que estos modelos requieren recursos considerables que limitan su uso en dispositivos con capacidad de cómputo reducida. La comprensión semántica avanzada —la capacidad de razonar sobre conceptos abstractos y escenarios complejos— sigue siendo un reto, a pesar de los avances en técnicas de grounding lingüístico y visual.

El futuro de los modelos VLA es prometedor, con investigaciones en curso que buscan hacer estos sistemas aún más versátiles y escalables. Enfoques como 3D-VLA, que integran la percepción 3D, y la mejora de la planificación de movimientos están ampliando las capacidades de estos modelos, permitiéndoles comprender y actuar en entornos tridimensionales complejos. Con el desarrollo continuo de modelos más potentes y la expansión de aplicaciones prácticas, estos sistemas podrían revolucionar aún más la robótica, abriendo camino a un futuro en el que los robots no solo respondan a órdenes, sino que también puedan interactuar y comprender el mundo de manera similar a los seres humanos.