Giuseppe Barile

31 mar 2025

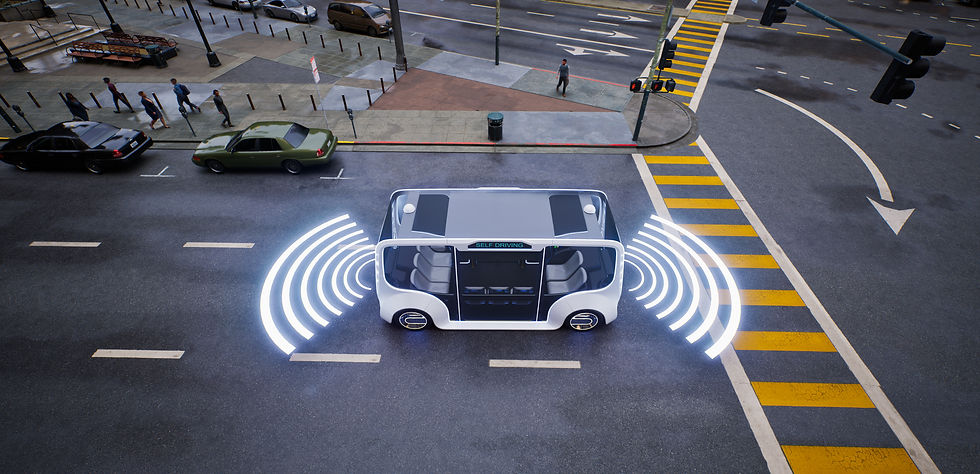

Dai laboratori alla realtà: i modelli Vision-Language-Action stanno rivoluzionando l’interazione tra robot e mondo fisico.

I modelli Vision-Language-Action (VLA) rappresentano l’avanguardia dell’intelligenza artificiale applicata alla robotica, con un impatto significativo su settori come l’automazione industriale, la navigazione autonoma e l’assistenza sanitaria. Questi sistemi multimodali combinano percezione visiva, comprensione linguistica e capacità di azione, creando robot in grado di interagire con il mondo fisico in modo più naturale ed efficiente. La ricerca in questo campo si sta sviluppando rapidamente, aprendo nuove possibilità e sfide da affrontare.

Al cuore dei modelli VLA ci sono tre moduli fondamentali che lavorano insieme per elaborare informazioni visive e linguistiche e rispondere con azioni precise. Il primo modulo, dedicato alla visione, utilizza reti neurali avanzate come le CNN (Convolutional Neural Networks) e i modelli ViT (Vision Transformers) per estrarre informazioni dalle immagini. Questi sono capaci di riconoscere oggetti, scene e situazioni complesse, grazie all’uso di pre-addestramento su dataset di grandi dimensioni. In questo contesto, vengono utilizzate anche tecniche di segmentazione semantica per migliorare la comprensione spaziale e il rilevamento degli oggetti.

Il secondo modulo è dedicato al linguaggio naturale. Qui si utilizzano modelli transformer di ultima generazione come BERT, T5, GPT-4 e PaLM 2 per elaborare e generare risposte linguistiche coerenti. Sono addestrati su vasti corpora di dati e utilizzano metodi avanzati come l’attenzione incrociata e il few-shot learning per adattarsi rapidamente a nuovi contesti, anche quando le informazioni disponibili sono limitate. L’obiettivo è garantire che il sistema possa correlare correttamente parole e immagini, per la comprensione del linguaggio in relazione agli stimoli visivi.

Il terzo modulo riguarda l’azione. Vengono utilizzano algoritmi avanzati di decision-making, come il reinforcement learning (RL), per prendere decisioni e compiere azioni. Grazie a tecniche come il Proximal Policy Optimization (PPO) e le reti neurali per la pianificazione dei movimenti, riescono a generare traiettorie di azione ottimali, adattandosi dinamicamente alle situazioni che si presentano. L’uso di apprendimento per imitazione, che consente al robot di apprendere osservando le azioni degli esseri umani, è un altro aspetto chiave nell’evoluzione di queste tecnologie.

Un aspetto innovativo nella ricerca sui modelli VLA è l’uso della fusione multimodale. Meccanismi come la cross-modal attention e l’utilizzo di spazi di embedding comuni permettono di integrare in modo fluido informazioni visive e linguistiche, migliorando la capacità di generare risposte coerenti e azioni precise. I modelli più avanzati, come Flamingo di DeepMind, utilizzano approcci di attenzione generalizzati, capaci di correlare in modo efficiente dati provenienti da diverse modalità, mentre tecniche come il contrastive learning affinano l’allineamento semantico tra visione e linguaggio.

Le applicazioni dei modelli VLA sono ampie e variegate. In ambito robotico, la capacità di comprendere e interagire con l’ambiente in tempo reale rende questi modelli ideali per compiti complessi come la manipolazione di oggetti o la navigazione autonoma. In particolare, progetti come RT-2, che integrano modelli pre-addestrati su larga scala con il controllo robotico, sono in grado di migliorare notevolmente le performance di sistemi robotici, anche in ambienti non precedentemente esplorati. Modelli open-source come OpenVLA, con il loro approccio versatile e altamente efficiente, stanno inoltre dimostrando come la robotica possa beneficiare di sistemi VLA per migliorare la precisione e l’adattabilità in contesti reali. Tuttavia, ci sono importanti sfide da affrontare. Una delle principali difficoltà riguarda l’adattabilità in scenari reali, dove le condizioni possono variare enormemente rispetto ai dati di addestramento. Inoltre, l’efficienza computazionale resta una barriera, poiché questi modelli richiedono risorse considerevoli che limitano l’utilizzo in dispositivi con capacità di calcolo ridotte. La comprensione semantica avanzata, ovvero la capacità di ragionare su concetti astratti e scenari complessi, rimane una questione aperta, nonostante i progressi nelle tecniche di grounding linguistico e visivo.

Il futuro dei modelli VLA è promettente, con ricerche in corso che mirano a rendere questi sistemi ancora più versatili e scalabili. Approcci come 3D-VLA, che integrano la percezione 3D, e il miglioramento della pianificazione del movimento, stanno ampliando le capacità di questi modelli, permettendo loro di comprendere e agire in ambienti tridimensionali complessi. Con il continuo sviluppo di modelli più potenti e l’espansione delle applicazioni pratiche, questi modelli potrebbero rivoluzionare ulteriormente la robotica, aprendo la strada a un futuro in cui i robot non solo rispondono ai comandi, ma possono interagire e comprendere il mondo in modo simile agli esseri umani.